IV. Linear Regression with Multiple Variables (Week 2)

- Multiple features

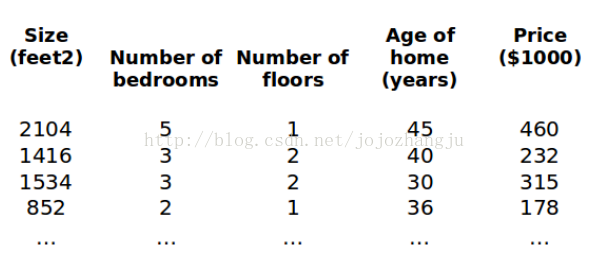

之前我們介紹了單變量/單特點(diǎn)的回歸模型,現(xiàn)在我們對(duì)房?jī)r(jià)預(yù)測(cè)模型增加更多的變量也就是更多的特點(diǎn),比如房間數(shù)、樓層、房齡等,從而構(gòu)成1個(gè)含有多個(gè)變量/特點(diǎn)的模型。

在增加了更多變量/特點(diǎn)以后,我們將引入1系列新的符號(hào)和解釋:

n 代表變量/特點(diǎn)的個(gè)數(shù)

代表第i個(gè)訓(xùn)練實(shí)例,也就是特點(diǎn)矩陣中的第i行,即1個(gè)向量

代表第i個(gè)訓(xùn)練實(shí)例,也就是特點(diǎn)矩陣中的第i行,即1個(gè)向量

代表第i個(gè)訓(xùn)練實(shí)例的第j個(gè)特點(diǎn),也就是特點(diǎn)矩陣中第i行的第j個(gè)特點(diǎn)

代表第i個(gè)訓(xùn)練實(shí)例的第j個(gè)特點(diǎn),也就是特點(diǎn)矩陣中第i行的第j個(gè)特點(diǎn)

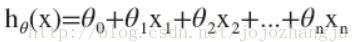

因此,多變量/特點(diǎn)的假定h可以表示為:

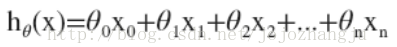

這個(gè)公式中有n+1個(gè)參數(shù)和n個(gè)變量,為了簡(jiǎn)化公式,我們令,則公式則表示為:

此時(shí)h中的參數(shù)是1個(gè)n+1維的向量,訓(xùn)練實(shí)例也都是n+1維的向量。

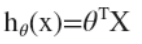

因此公式可以簡(jiǎn)化為:

其中上標(biāo)T代表了矩陣的轉(zhuǎn)置。

- Gradient descent for multiple variables

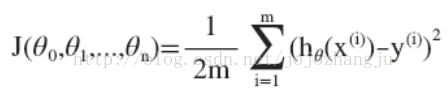

與單變量/特點(diǎn)線性回歸相似,在多變量/特點(diǎn)線性回歸中,我們也將定義1個(gè)代價(jià)函數(shù),即:

我們的目標(biāo)和單變量/特點(diǎn)線性回歸中的問題相同,就是要找出使得代價(jià)函數(shù)最小的參數(shù)組合。

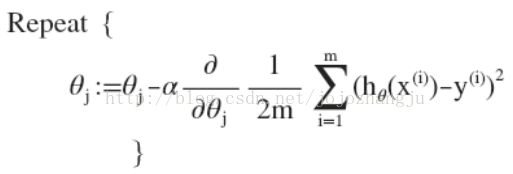

因此,多變量/線性回歸梯度降落算法為:

即:

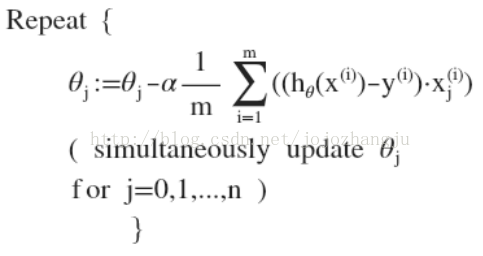

求導(dǎo)數(shù)后可以得到:

以后,我們通過隨機(jī)更新1系列的值并計(jì)算代價(jià)函數(shù),直到收斂。