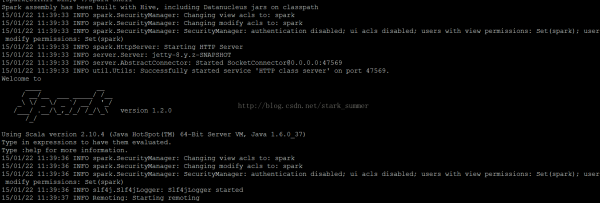

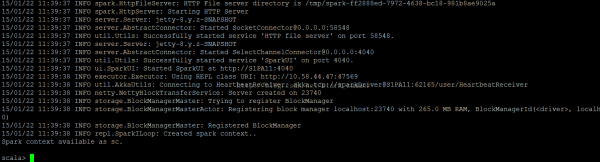

首先以spark的本地模式測試spark API,以local的方式運行spark-shell:

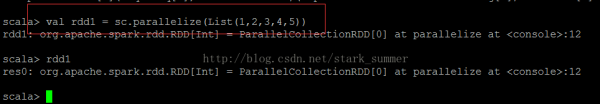

先從parallelize入手吧:

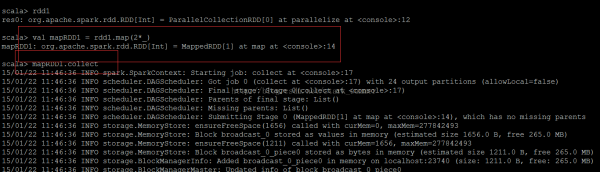

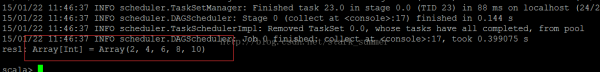

map操作后結果:

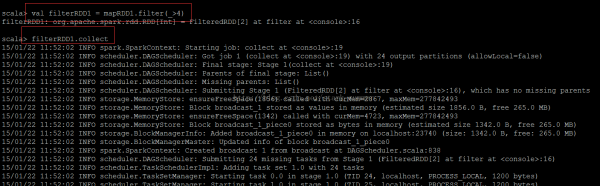

下面看下 filter操作:

filter履行結果:

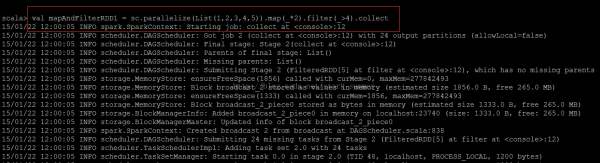

我們用最正宗的scala函數(shù)式編程的風格:

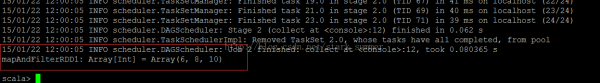

履行結果:

從結果 可以看出來,與之前那種分步奏方式結果是1樣的

但采取這類方式,即是復合scala風格的寫法,也是符合spark的利用程序風格的寫法,在spark的編程中,大多數(shù)功能的實現(xiàn)都是只要1行代碼便可完成。

上一篇 ssh自動登錄工具

下一篇 Notification用法